복습

TD로도 Off-policy를 할 수 있겠구나.

TD(0) (복습)

TD(0) 현재 보상인 Rt+1과 한번 감가한 다음state의 value fucntion

Off-policy MC(복습)

Off-policy를 하는데 Correction term이 존재했다.

Importance sampling for Off-Policy TD

Importance sampling의 단점

Q-Learning : An Off-Policy TD Control

Q-Learning이 TD의 유일한 Off-Policy 방법은 아니다.

TD의 다양한 Off-Policy 방법이 존재하나 Q-Learning이 가장 구현이 쉽다.

어떤 정책을 사용하든 행동 a를 구했다고 생각하고

행동 a를 환경에 가한 후 , 환경으로부터 보상과 다음상태를 관측하게 된다.

1은 보상받은 것. 2는 s'을 관측했고 Q값은 알고있으니까 다음상태에 대해서 가장 최대값을 주는 a'을 찾게된다.

2를 다음상태의 추정치로 사용하게 되기때문에 감마로 한번 감소시켜준다.

Importance sampling term이 없는것을 이야기하기위해서 가치반복 알고리즘을 다시한번 봐야한다.

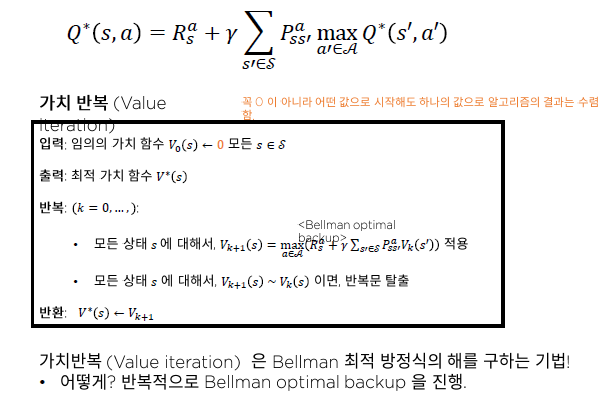

Bellman 최적 방정식, 가치반복 알고리즘

임의의 가치함수로부터 최적 가치함수를 찾는 알고리즘.

매 상태에서 bellman optimal backup을 실행.

Q러닝이 이를 근사적으로 수행하고 있다는 것을 확인 할 수 있을 것임.

Bellman 최적 방정식의 샘플기반 추산 == Q-Learning objective

첫번째 줄은 기댓값 형태로 표현할 수 있다. 그러나

지금 dp를 통해서 푸는 것이 아니기 때문에 1을 알수가 없음.

샘플을 통해서 추산해야한다.

그럼 Q-Learning과 동일한 식이 도출된다.

여기에서 2를 계산하게 될때 행동정책이나 평가정책의 영향을 받지 않는다.

단지 우리가 알고있는 현재 value function에만 영향을 받게 된다.

Importance sampling을 우리가 타겟(evaluation 하고싶은)π와 행동정책 μ 사이의 상관관계를 지워주기위해 사용했는데,

이 수식을 계산할 때 μ와 π가 아예 나오지 않는다는 것은 importance sampling을 할 이유가 사라진다.

Q-Learning이 만능은 아니다

Maximization bias 라는 단점... 나중에 알아보자.

Q-Learner = RL Agent ..

'인공지능 > Reinforce_Learning' 카테고리의 다른 글

| [PART 03] CH02. 심층 신경망을 활용한 함수근사(선형근사) (0) | 2020.12.29 |

|---|---|

| [PART3] CH01. 함수근사 소개 (0) | 2020.12.25 |

| [PART2] CH05. Off-policy MC control (0) | 2020.12.23 |

| [PART2] CH04. SARSA TD 기법을 활용한 최적정책 찾기 (0) | 2020.12.22 |

| [PART2] CH04. Monte Carlo 기법을 활용한 최적 정책 찾기 (0) | 2020.12.22 |